RESUMO Livro sobre superinteligência do sueco Nick Bostrom reanimou os debates acerca da criação de máquinas capazes de superar a capacidade do cérebro humano. Enquanto o autor levanta possíveis riscos de descontrole, estimativas sugerem que tal inteligência poderá se tornar realidade em algumas décadas.

| Caetano de Almeida | ||

|

||

A cura de todas as doenças; a solução para as guerras; um juiz infalível para todos os conflitos; o sentido da vida. Seria esperar demais que essas questões pudessem se resolver pelo advento de uma inteligência que em muito –muito mesmo– superasse a média humana?

Tal intelecto não precisaria estar limitado por uma caixa craniana; a rigor, ele não precisaria nem mesmo estar vinculado a um corpo. Poderia se tratar de uma rede ou de uma entidade digital, na nuvem. Quem sabe um ciborgue –meio humano, meio máquina. Mais factível é imaginar que ele seja um supercomputador, mas sua forma só será de fato conhecida quando nos for dado chegar a ele.

Os caminhos, perigos e estratégias relativos a essa busca por uma inteligência sobrehumana são o tema de Nick Bostrom em "Superintelligence - Paths, Dangers, Strategies" [Oxford University Press, 352 págs., R$ 58,71, em pré-venda até 1/5 na Amazon.com.br; R$ 59,22 em e-book Kindle].

No livro, o filósofo sueco, professor na Universidade de Oxford, analisa não só os rumos desse campo de estudos como os eventuais riscos de um cataclismo originado dele. Num cenário distópico que se aproxima do filme "Matrix", o que impediria uma máquina (ou outra forma que desse abrigo a essa superinteligência) de se tornar criativa e autônoma o bastante a ponto de decidir que o ser humano devesse ser domado ou eliminado?

De forma talvez menos atemorizante, mas ainda assim desoladora, poderíamos simplesmente ser deixados de lado, observando a evolução das máquinas tal como os insetos presenciaram o surgimento do Homo sapiens, sem entender o que se passava ou sem auferir benefício algum da existência dessa nova espécie.

REBELDES

Atualmente, as máquinas só conseguem fazer aquilo para o que foram programadas. Para que viessem a se tornar uma ameaça ou tão somente rebeldes, seria necessário que adquirissem autoconsciência. Na prática, elas precisariam ser capazes de reescrever seu próprio código –a essência de seu "ser".

Para alguns estudiosos, como o filósofo americano John Searle, da Universidade da Califórnia, o risco não existe: se de fato houver tamanha inteligência, ela estará automaticamente domada e limitada pela própria arquitetura computacional. Para outros estudiosos, como Bostrom, é apenas questão de tempo para que as máquinas se livrem de suas amarras.

O professor, que também tem formação em computação e física, está entusiasmado com o fato de que o assunto tornou-se alvo de atenção, em especial nos últimos dois anos, desde que seu livro foi lançado, em 2014.

Na opinião de Bostrom, se as pessoas estiverem devidamente alertadas para os riscos, resta um "desafio": investir as energias numa solução construtiva para o "problema do controle", como diz à Folha. Ele afirma que seu objetivo é lançar as bases para que a colaboração entre indústria e academia se efetive e possa guiar as pesquisas para o futuro, atentando para princípios morais humanos.

Para ele, a superinteligência nos conduziria rapidamente a um estado de maturidade tecnológica no qual "muitas coisas que hoje parecem ficção científica seriam possíveis". Por exemplo: "Uma extrema extensão do tempo de vida, a colonização do espaço, o upload de mentes em computadores e muitas outras aplicações que não dependam de violar as leis da física e as limitações da matéria".

Para que a superinteligência seja realmente usada para finalidades como as que elenca é crucial resolver a questão do controle. "Uma vez resolvida, dependerá de escolhermos ou não direcionar a mira para esses objetivos", diz.

Bostrom inicia seu livro com uma espécie de fábula que tem a função de ilustrar o "problema do controle". Nela, um bando de pardais se mostra entusiasmado com a ideia de encontrar uma coruja que seria a solução de suas dificuldades cotidianas, como construir ninhos e defender-se de predadores. Passam, então, a buscar tal criatura. Aceitariam, dizem, mesmo um filhote de coruja. Na pior das hipóteses, um ovo estaria de bom tamanho.

Um pardal cauteloso, representação alegórica do próprio autor, faz um alerta: nenhum deles entende nada da arte de domesticar corujas e essa ausência de conhecimento deveria ser a primeira preocupação do grupo, antes de introduzir nele tal pássaro. Enquanto os demais saem em busca de sua suposta salvadora, o pardal cauteloso fica para trás, tentando resolver o problema que ele próprio apresentou. Bostrom não nos diz se os pardais foram bem-sucedidos em sua empreitada –no mundo a que a fábula alude, a procura segue em curso.

PRIORIDADES

Eduardo Valle, professor de computação da Universidade Estadual de Campinas, é um entusiasta da inteligência artificial. À diferença do filósofo sueco, porém, Valle vê a questão do controle como pouco urgente no quadro geral dos riscos à vida humana. Em uma escala de prioridades, a superinteligência estaria bastante atrás do desastre potencial que representam as centenas de bombas atômicas ainda espalhadas pelo mundo, a ameaça climática ou uma nova guerra mundial.

"O que eu não gostaria é que esse assunto da inteligência artificial ganhasse espaço na política pública", afirma. Seria, para Valle, gastar energia e dinheiro com um problema ainda um tanto distante.

| Caetano de Almeida | ||

|

||

Ele conta que a área de estudo já passou por momentos de entusiasmo seguidos por grandes invernos. É possível que ainda aconteça um longo e gélido período antes que sobrevenha um acontecimento sensacional. A desilusão posterior ao excesso de expectativa poderia atrasar ainda mais essa chegada.

Os avanços da nanotecnologia, da computação e da robótica não oferecem, por ora, uma saída para a maior de todas as questões humanas –a do sentido da vida. No entanto, pode ser que a extinção da espécie por outras causas possa estar à porta, tornando ocioso buscar a resposta.

Para Bostrom, o sentido da vida pode ser resumido em uma palavra: reprodução. A resposta soa biológica e simplista, mas revela sua filosofia: a morte é um problema porque, quando alguém morre, um bom bocado de conhecimento se perde. Seria como se uma biblioteca se deteriorasse por causa de um prazo de validade.

Nesse sentido, reproduzir-se talvez se ofereça como a única resposta, ainda que não totalmente eficiente, contra esse risco. Mais descendentes significam mais genes e, portanto, mais chance de alguns de nós sobreviverem a outro problema listado pelo filósofo –o risco de extinção, seja por uma superinteligência cruel ou pelo impacto de um asteroide no planeta.

Bostrom calcula que haja uma chance de até 20% de não sobrevivermos ao século 21. No caso de que sobrevivamos, porém, poderia ter início um novo ciclo da humanidade, marcado pela tecnologia e a inteligência artificial, que permitiria, quiçá, novas compreensões para a razão da existência.

Algumas estimativas são possíveis, a partir de números obtidos pelo próprio Bostrom por meio de enquetes realizadas em congressos e consultando os mais produtivos pesquisadores da área de inteligência artificial: há 50% de chance de uma inteligência artificial de nível humano existir já em 2040. Dando mais 35 anos de prazo, a chance de uma máquina ser tão esperta quanto um humano em 2075 vai para 90%.

Uma vez atingido o estágio humano, seria plausível considerar que um grau de inteligência a nós inconcebível fosse superado –por exemplo, porque máquinas poderiam trabalhar paralelamente na resolução conjunta de um problema só, somando suas capacidades; incansáveis, poderiam, ainda, construir máquinas ainda mais inteligentes do que elas próprias.

O momento crítico em que a capacidade intelectual humana for alcançada pela máquina e a partir do qual a taxa de crescimento da inteligência rumar para o infinito recebe o nome de "singularidade" –a partir dele não há mais volta.

Ainda segundo o levantamento do filósofo, há 10% de chance de a "superinteligência" nascer em até dois anos após a inteligência humana ser atingida; as chances de que ela se torne um fato após o evento em 30 anos são de 75%.

LINGUAGEM

Nosso sistema nervoso, mais complexo que o de outros primatas, nos garantiu uma inteligência também superior, com os resultados decorrentes dela, como a linguagem, as ferramentas, a ciência, o domínio da natureza.

No âmbito do artificial, a noção do que inteligente significa é menos óbvia. Embora seja bastante rudimentar, um termostato de geladeira poderia ser considerado inteligente. Afinal, ele analisa a situação e reage a ela: se a temperatura sobe, ele resfria; se esfriou demais, deixa aquecer.

Parece mais compreensível chamar de inteligente uma máquina capaz de tarefas menos triviais, como bater um campeão mundial de xadrez, feito alcançado pelo computador Deep Blue, que venceu o grão-mestre Garry Kasparov em 1997 –mesmo que a vitória da máquina tenha sido atribuída, mais tarde, a uma falha de concentração de Kasparov diante de um movimento aparentemente errado, ou ilógico, do computador.

Em março deste ano, um software foi programado para jogar go e derrotou Lee Sedol, considerado um dos melhores do mundo nesse tradicional jogo de tabuleiro chinês, no qual, em uma grade quadrada de 19 por 19, se espalham peças brancas ou pretas. Ao cercar as peças do adversário, elas são capturadas. É uma miríade de possibilidades para um mesmo tabuleiro –ou campo de batalha–, fazendo o xadrez parecer simples.

A façanha do software AlphaGo foi vista com interesse, pois, a cada rodada, uma quantidade imensa de movimentos é possível, o que faz com que o jogo, ao menos entre humanos, dependa de uma boa dose de intuição. O software em questão é resultado de um sistema programado para aprender, se adaptar e, de algum modo, mimetizar os "palpites" humanos.

No artigo "IA "" Inteligência Artificial ou Imbecilidade Automática?", de 2009 (disponível online em www.ime.usp.br/~vwsetzer/IAtrad.html ), Valdemar Setzer afirma que máquinas podem ser extremamente eficientes em executar tarefas mas que jamais poderão "pensar".

Na opinião desse professor aposentado de computação da USP, não é possível definir a origem dos pensamentos, dos sentimentos ou da vontade; a "causa primeira" de uma ação humana qualquer, como mover um braço, é nebulosa.

TESTE

Para Eduardo Valle, seria "desonesto" esperar que uma máquina pudesse pensar: se ela consegue passar no teste de Turing, não haveria mais o que se exigir dela.

O teste é um modelo de avaliação de "inteligência de máquina" proposto pelo cientista britânico Alan Turing (1912-54). Nele, uma pessoa faz perguntas a uma máquina e recebe respostas. A ideia é que o diálogo seja o mais próximo possível daquele que haveria entre dois humanos.

Para que a máquina fosse aprovada no teste, ela deveria ser abastecida com um importante repertório linguístico e social, além de contar com um excelente programa de gerenciamento dessas informações –para nossa sorte, ou azar, isso ainda não aconteceu.

Um estágio posterior ainda poderia ser imaginado. Para tanto, a computação e a robótica teriam de se unir para produzir uma máquina capaz de se comunicar não verbalmente, com gestos e expressões faciais e corporais, o que lhe daria a proximidade máxima das características humanas no teste de Turing. O passo final seria que a máquina fosse indistinguível da forma humana.

Essa transformação tem um exemplo ficcional na trama do filme "O Homem Bicentenário" (1999). O androide interpretado por Robin Williams (1951-2014) vai sendo informal e gradualmente aprovado em "provas de humanidade", até chegar ao ponto que ele mesmo e os que nasceram humanos o reconhecem como homem.

Na ficção, o estágio humano de inteligência é alcançado quando as máquinas adquirem a capacidade de "aprender". Na realidade, isso não é algo tão distante –o já citado AlphaGo seria um exemplo disso; programas que reconhecem padrões e identificam elementos em imagens (hoje em nível experimental e úteis, por exemplo, para a automação de veículos) são outro.

Funções mais mundanas também são fruto de avanços nesse sentido. É o caso de radares de velocidade: neles, a placa é reconhecida, lida, confrontada com o banco de dados e a multa é emitida. O ser humano é praticamente dispensável no processo.

Em cinco anos, os avanços na pesquisa em inteligência artificial (IA) nos levaram a um ponto inesperado, diz Valle. Hoje, por exemplo, programas podem reconhecer categorias semânticas complexas –como vídeos considerados inapropriados pelo YouTube por conterem pornografia e violência.

Uma das linhas de pesquisa do professor da Unicamp é dedicada ao diagnóstico automatizado de doenças como melanoma e retinopatia diabética. "A evolução da área é rápida e empolgante."

"Um sistema inteligente é aquele que percebe o ambiente e atua de maneira automática", explica o engenheiro João Bernartt, dono da Chaordic, que explora sistemas de recomendação de produtos para varejo on-line.

O objetivo do trabalho de Bernartt, que tem mestrado em IA, é observar padrões em dados de consumo na internet: "A pessoa pesquisa um produto, clica em outro, volta para o primeiro e, eventualmente, compra. Toda essa informação de procura, clique e compra cria sistemas preditivos".

A análise desses dados coletados propicia anúncios e ofertas personalizados, que tendem a ampliar as vendas virtuais. São algoritmos que "aprendem" e que geram receitas para seus criadores.

Não é muito distante do que faz o Google. Mais do que um buscador, ele "adivinha" –com base em pesquisas anteriores feitas por aquele usuário e em associações entre termos de busca– o que a pessoa quer, colocando os resultados mais relevantes na primeira página. Se o que as pessoas querem está nas páginas seguintes, o programa "aprende", e os resultados sobem –e o poder de predição é incrementado.

Até por contingências físicas, a complexidade da mente humana não se mede pela capacidade de acumular informação, mas de processá-la. Não é possível decorar tudo: datas, nomes, telefones, locais por onde passou, senhas, modelos de veículos. A memória falha.

Cada neurônio, explica Bernartt, funciona como um computador. Em funcionamento simultâneo, nossos bilhões de neurônios formam um grande aglomerado de processadores. Os computadores atuais têm poucos núcleos de processamento –quatro, em geral.

Ainda há poucas linguagens de programação (as responsáveis por dar instruções aos computadores) capazes de otimizar o uso de vários processadores para que cada um deles realize uma parte da tarefa e para que façam com que o trabalho seja eficientemente integrado visando uma tarefa final.

Uma metáfora empresarial para o problema seria a dificuldade de encontrar um gerente (linguagem) capaz de ordenar e receber o trabalho de vários analistas (processadores), a fim de compor um relatório final.

Dito de outra forma, falta uma linguagem para que um cérebro (ou um modelo computacional do órgão) possa ser adequadamente programado.

Especula-se que talvez se deva a essa peculiar arquitetura computacional o fato de que nosso cérebro seja mais capaz de aprender do que de lembrar de coisas.

CONSCIÊNCIA

Talvez derive dessa natureza única e peculiar a explicação para uma questão que permeia obras de ficção científica e ocupa a mente de filósofos e cientistas: a da consciência.

Alguns pesquisadores, como Setzer, acreditam que a consciência e os pensamentos podem ter uma origem não física –o que abriria espaço para a existência de algo como um espírito, que, por ser parte integrante fundamental dessa característica, impediria que máquinas pudessem ter uma noção de si.

Mas para a maioria dos especialistas é possível que exista um nível de complexidade ou um "software" responsável pela presença de consciência. Se partirmos do princípio de que ela possa ser representada por um programa computacional superavançado, abre-se caminho para especulações diversas e interessantes sobre a finitude.

Se a consciência é a essência do que somos, chegar a um ponto em que ela pudesse ser simulada equivaleria a nos fazer imortais, como sonham Bostrom e muitos outros.

Nem todo mundo, porém, consegue ver a questão do que somos de forma tão pragmática. Um dilema proposto pelo professor Eduardo Valle ilustra isso de forma curiosa.

Imagine-se em um futuro não muito distante, no qual uma forma de superinteligência, devidamente domada, trouxe avanços científicos quase inimagináveis. A Terra, porém, está fadada ao colapso. Aos seres humanos que não querem ver o fim do mundo é dada uma das duas opções abaixo.

1) Sair do planeta em uma espaçonave, com destino a uma lua de Júpiter –um refúgio feito habitável pelas novas tecnologias. O problema é que há uma chance maior que 50% de a nave simplesmente não chegar ao destino, e a viagem terminar numa gélida morte no vácuo espacial, ou mesmo antes, numa explosão na hora do lançamento;

2) Ser escaneado e, em um processo que destruiria a mente/consciência na origem, criar uma versão virtual de si, em um computador (ou em um robô), localizado na mesma lua de Júpiter. Todo o processo duraria alguns minutos, em vez dos meses que demoraria uma viagem espacial. O problema é que há uma chance de 2% de os dados serem corrompidos e, nesse caso, nada restaria dos que fizessem essa escolha.

Os que creem que a humanidade nasce da interação de mente com corpo e cérebro, ou acham que a essência da vida reside em algo semelhante a um espírito, veem a segunda hipótese como morte certa. Para estes, o processo levado a cabo no computador ou robô de Júpiter geraria apenas uma cópia sem alma. Essas pessoas optariam pela primeira opção, por maior que fosse o risco.

Para quem, porém, acredita que a humanidade é pura mente, como se ela fosse um software alojado no hardware do cérebro, optar pela segunda alternativa é ter 98% de chance de viver, virtualmente, para sempre.

*

O teste fictício de Voight-Kampff, criado por Philip K. Dick em "Androides Sonham Com Ovelhas Elétricas?" (Aleph) para determinar se uma criatura é humana ou androide, e que também aparece no filme baseado em seu livro, "Blade Runner", pode ser feito online (em inglês) aqui

GABRIEL ALVES, 30, é repórter da Folha, biomédico e doutor em ciências pela Universidade Federal de São Paulo.

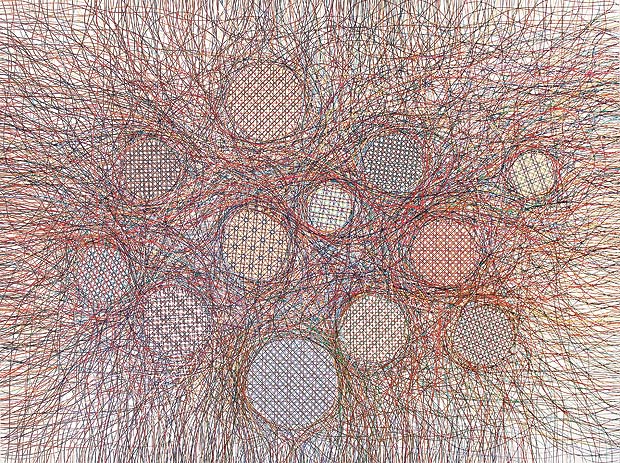

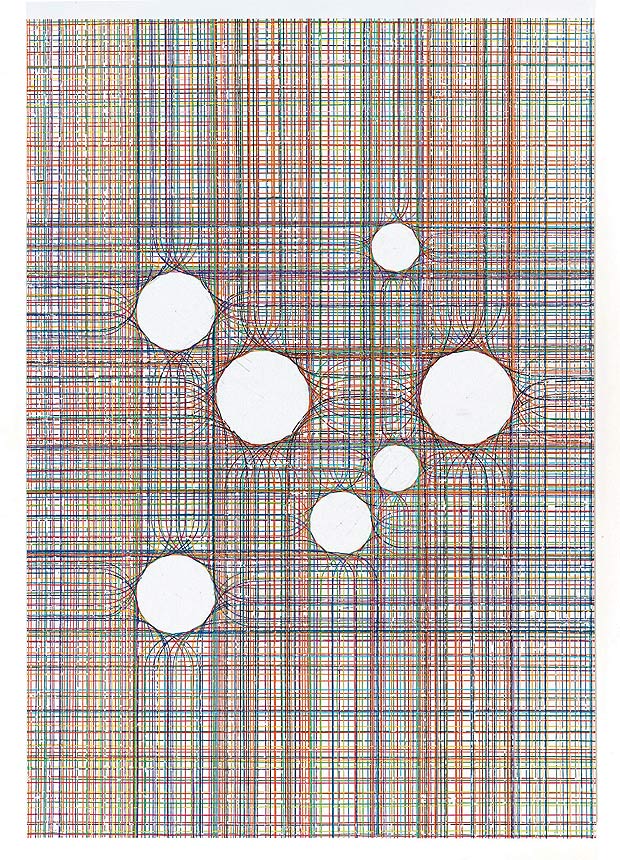

CAETANO DE ALMEIDA, 51, é artista plástico e expõe na galeria Luisa Strina até 21/5.